딥 러닝, AI 및 ML과 같은 새로운 기술의 등장으로 클라우드 GPU에 대한 수요가 높아졌습니다.

조직에서 3D 시각화, 머신 러닝(ML), 인공 지능(AI) 또는 일종의 헤비 컴퓨팅을 처리하는 경우 GPU 계산을 수행하는 방법이 매우 중요합니다.

전통적으로 조직의 딥 러닝 모델은 교육 및 계산 작업에 많은 시간이 소요되었습니다. 시간을 낭비하고 비용을 많이 들이고 저장 공간과 공간 문제를 남겨 생산성을 떨어뜨리곤 했습니다.

새로운 시대의 GPU는 이 문제를 해결하도록 설계되었습니다. AI 모델에 대한 대량 계산과 더 빠른 학습을 병렬로 수행하는 고효율을 제공합니다.

Indigo 연구에 따르면 GPU는 다음을 제공할 수 있습니다. 250배 빨라짐 딥 러닝과 관련된 신경망을 훈련하는 동안 CPU보다 성능이 좋습니다.

그리고 클라우드 컴퓨팅의 발전으로 더 빠른 성능, 손쉬운 유지 관리, 비용 절감, 빠른 확장 및 시간 절약을 제공하여 데이터 과학 및 기타 신흥 기술의 세계를 변화시키고 있는 클라우드 GPU가 있습니다.

이 기사에서는 클라우드 GPU 개념, AI, ML, 딥 러닝 및 선호하는 클라우드 GPU를 배포하기 위해 찾을 수 있는 최고의 클라우드 GPU 플랫폼과 어떤 관련이 있는지 소개합니다.

의 시작하자!

목차

클라우드 GPU란?

클라우드 GPU를 이해하기 위해 먼저 GPU에 대해 이야기합시다.

GPU(그래픽 처리 장치)는 이미지 또는 그래픽 생성을 가속화하기 위해 메모리를 빠르게 변경하고 조작하는 데 사용되는 특수 전자 회로를 나타냅니다.

최신 GPU는 CPU(중앙 처리 장치)보다 병렬 구조로 인해 이미지 처리 및 컴퓨터 그래픽을 조작하는 데 더 높은 효율성을 제공합니다. GPU는 마더보드에 내장되거나 PC의 비디오 카드 또는 CPU 다이에 배치됩니다.

클라우드 GPU(Cloud Graphics Unit)는 클라우드에서 대규모 AI 및 딥 러닝 워크로드를 처리하기 위해 애플리케이션을 실행하는 데 도움이 되는 강력한 하드웨어 가속 기능을 갖춘 컴퓨터 인스턴스입니다. 장치에 물리적 GPU를 배포할 필요가 없습니다.

일부 인기 있는 GPU는 NVIDIA, AMD, Radeon, GeForce 등입니다.

GPU는 다음에서 활용됩니다.

- 휴대 전화

- 게임 콘솔

- 워크스테이션

- 임베디드 시스템

- 개인용 컴퓨터

GPU는 무엇에 사용됩니까?

다음은 GPU의 몇 가지 사용 사례입니다.

- 이미지 인식을 위한 AI 및 ML에서

- 3D 컴퓨터 그래픽 및 CAD 도면에 대한 계산

- 텍스처 매핑 및 렌더링 폴리곤

- 정점을 좌표계로 변환 및 회전과 같은 기하학적 계산

- 텍스처와 정점을 조작하기 위해 프로그래밍 가능한 셰이더 지원

- GPU 가속 비디오 인코딩, 디코딩 및 스트리밍

- 그래픽이 풍부한 게임 및 클라우드 게임

- 범용 GPU의 병렬 처리 기능이 필요한 광범위한 수학적 모델링, 분석 및 딥 러닝.

- 영상편집, 그래픽디자인, 콘텐츠제작

클라우드 GPU의 이점은 무엇입니까? 👍

Cloud GPU 사용의 주요 이점은 다음과 같습니다.

높은 확장성

조직을 확장하려는 경우 작업 부하가 결국 증가합니다. 증가된 워크로드에 따라 확장할 수 있는 GPU가 필요합니다. Cloud GPU를 사용하면 번거로움 없이 쉽게 GPU를 추가할 수 있으므로 증가된 워크로드를 충족할 수 있습니다. 반대로 축소하려는 경우에도 빠르게 가능합니다.

비용 최소화

엄청나게 비싼 고성능 물리적 GPU를 구입하는 대신 시간당 더 저렴한 비용으로 클라우드 GPU를 대여할 수 있습니다. 클라우드 GPU를 많이 사용하지 않더라도 비용이 많이 드는 물리적 GPU와 달리 클라우드 GPU를 사용한 시간만큼 요금이 부과됩니다.

로컬 리소스 지우기

클라우드 GPU는 컴퓨터에서 상당한 공간을 차지하는 물리적 GPU와 달리 로컬 리소스를 사용하지 않습니다. 말할 것도 없이 대규모 ML 모델을 실행하거나 작업을 렌더링하면 컴퓨터 속도가 느려집니다.

이를 위해 컴퓨터에 부담을 주지 않고 컴퓨팅 파워를 클라우드에 아웃소싱하는 것을 고려하여 손쉽게 사용할 수 있습니다. 작업량과 계산 작업을 처리하기 위해 모든 압력을 가하는 대신 컴퓨터를 사용하여 모든 것을 제어하십시오.

시간 절약

Cloud GPU는 디자이너에게 더 빠른 렌더링 시간으로 빠른 반복의 유연성을 제공합니다. 몇 시간 또는 며칠이 걸리던 작업을 몇 분 안에 완료하여 많은 시간을 절약할 수 있습니다. 따라서 팀의 생산성이 크게 향상되어 렌더링이나 계산 대신 혁신에 시간을 투자할 수 있습니다.

GPU는 딥 러닝과 AI에 어떻게 도움이 되나요?

딥 러닝은 인공 지능의 기초입니다. 인공 신경망(ANN)의 도움으로 표현 학습을 강조하는 고급 ML 기술입니다. 딥 러닝 모델은 대규모 데이터 세트 또는 고도로 계산되는 프로세스를 처리하는 데 사용됩니다.

그렇다면 GPU는 어떻게 등장할까요?

GPU는 병렬 계산 또는 여러 계산을 동시에 수행하도록 설계되었습니다. GPU는 딥 러닝 모델의 기능을 활용하여 대규모 계산 작업을 가속화할 수 있습니다.

GPU에는 많은 코어가 있으므로 우수한 병렬 처리 계산을 제공합니다. 또한 딥 러닝 시스템을 위한 방대한 양의 데이터를 수용할 수 있도록 더 높은 메모리 대역폭을 가지고 있습니다. 따라서 AI 모델 훈련, CAD 모델 렌더링, 그래픽이 풍부한 비디오 게임 등에 널리 사용됩니다.

또한 여러 알고리즘을 동시에 실험하고 싶다면 수많은 GPU를 개별적으로 실행할 수 있습니다. 병렬 처리 없이 별도의 GPU에서 다른 프로세스를 용이하게 합니다. 이를 위해 여러 물리적 시스템 또는 단일 시스템에서 여러 GPU를 사용하여 대용량 데이터 모델을 배포할 수 있습니다.

클라우드 GPU를 시작하는 방법

클라우드 GPU를 시작하는 것은 로켓 과학이 아닙니다. 사실 기본만 알면 모든 것이 쉽고 빠릅니다. 먼저 GCP(Google Cloud Platform)와 같은 클라우드 GPU 제공업체를 선택해야 합니다.

다음으로 GCP에 가입합니다. 여기에서 클라우드 기능, 스토리지 옵션, 데이터베이스 관리, 애플리케이션과의 통합 등과 같이 함께 제공되는 모든 표준 이점을 활용할 수 있습니다. Jupyter Notebook처럼 작동하는 Google Colboratory를 사용하여 하나의 GPU를 무료로 사용할 수도 있습니다. 마지막으로 사용 사례에 맞는 GPU 렌더링을 시작할 수 있습니다.

따라서 클라우드 GPU가 AI 및 대규모 워크로드를 처리하는 데 사용할 수 있는 다양한 옵션을 살펴보겠습니다.

리노드

리노드 비디오 처리, 과학 컴퓨팅, 기계 학습, AI 등과 같은 병렬 처리 워크로드를 위한 주문형 GPU를 제공합니다. NVIDIA Quadro RTX 6000, Tensor, RT 코어로 가속화된 GPU 최적화 VM을 제공하고 CUDA 성능을 활용하여 레이 트레이싱 워크로드, 딥 러닝 및 복잡한 처리를 실행합니다.

Linode GPU에서 액세스하여 GPU 성능을 활용하고 클라우드의 실제 가치 제안을 활용하여 자본 비용을 운영 비용으로 전환하십시오. 또한, Linode를 사용하면 하드웨어에 대해 걱정하는 대신 핵심 역량에 집중할 수 있습니다.

Linode GPU는 비디오 스트리밍, AI 및 기계 학습과 같은 복잡한 사용 사례에 활용하기 위한 장벽을 제거합니다. 또한 예상 워크로드에 필요한 마력에 따라 모든 인스턴스에 대해 최대 4개의 카드가 제공됩니다.

Quadro RTX 6000에는 4,608개의 CUDA 코어, 576개의 Tensor 코어, 72개의 RT 코어, 24GB GDDR6 GPU 메모리, 84T RTX-OPS, 10Giga Rays/sec Rays Cast 및 16.3 TFLOP의 FP32 성능이 있습니다.

전용 플러스 RTX6000 GPU 요금제는 시간당 $1.5입니다.

페이퍼스페이스 코어

차세대 가속 컴퓨팅 인프라로 조직 워크플로를 강화하십시오. 페이퍼스페이스 코어. 사용하기 쉽고 간단한 인터페이스를 제공하여 Mac, Linux 및 Windows용 간단한 온보딩, 협업 도구 및 데스크탑 앱을 제공합니다. 무제한 컴퓨팅 성능을 통해 수요가 많은 응용 프로그램을 실행하는 데 사용합니다.

CORE는 초고속 네트워크, 즉각적인 프로비저닝, 3D 앱 지원 및 프로그래밍 방식 액세스를 위한 전체 API를 제공합니다. 한 곳에서 간편하고 직관적인 GUI를 사용하여 인프라에 대한 전체 보기를 얻을 수 있습니다. 또한 강력한 도구를 제공하고 기계, 네트워크 및 사용자를 필터링, 정렬, 연결 또는 생성할 수 있는 CORE의 관리 인터페이스로 탁월한 제어 기능을 얻을 수 있습니다.

CORE의 강력한 관리 콘솔은 Active Directory 통합 또는 VPN 추가와 같은 작업을 빠르게 수행합니다. 또한 복잡한 네트워크 구성을 쉽게 관리하고 몇 번의 클릭으로 더 빠르게 작업을 완료할 수 있습니다.

또한 선택 사항이지만 작업에 도움이 되는 많은 통합을 찾을 수 있습니다. 이 클라우드 GPU 플랫폼으로 고급 보안 기능, 공유 드라이브 등을 얻으십시오. 교육 할인, 청구 알림, 잠시 청구 등을 통해 저렴한 GPU를 즐기십시오.

시간당 $0.07의 시작 가격으로 워크플로에 단순성과 속도를 추가하십시오.

구글 클라우드 GPU

다음을 통해 과학 컴퓨팅, 3D 시각화 및 기계 학습을 위한 고성능 GPU를 얻으십시오. 구글 클라우드 GPU. HPC 속도를 높이고 가격대와 성능에 맞는 다양한 GPU를 선택하고 기계 사용자 정의 및 유연한 가격 책정으로 워크로드를 최소화하는 데 도움이 될 수 있습니다.

또한 NVIDIA K80, P4, V100, A100, T4 및 P100과 같은 많은 GPU를 제공합니다. 또한 Google Cloud GPU는 개별 워크로드에 대해 모든 인스턴스에서 메모리, 프로세서, 고성능 디스크 및 최대 8개의 GPU의 균형을 유지합니다.

또한 업계 최고의 네트워킹, 데이터 분석 및 스토리지에 액세스할 수 있습니다. GPU 장치는 일부 지역의 특정 영역에서만 사용할 수 있습니다. 가격은 지역, 선택하는 GPU 및 컴퓨터 유형에 따라 다릅니다. Google Cloud 가격 계산기에서 요구사항을 정의하여 가격을 계산할 수 있습니다.

또는 다음 솔루션으로 이동할 수 있습니다.

탄력적 GPU 서비스

탄력적 GPU 서비스 (EGS)는 GPU 기술로 병렬 및 강력한 컴퓨팅 기능을 제공합니다. 비디오 처리, 시각화, 과학 컴퓨팅 및 딥 러닝과 같은 많은 시나리오에 이상적입니다. EGS는 NVIDIA Tesla M40, NVIDIA Tesla V100, NVIDIA Tesla P4, NVIDIA Tesla P100 및 AMD FirePro S7150과 같은 여러 GPU를 사용합니다.

온라인 딥 러닝 추론 서비스 및 교육, 콘텐츠 식별, 이미지 및 음성 인식, HD 미디어 코딩, 화상 회의, 원본 필름 수리, 4K/8K HD 라이브와 같은 혜택을 받을 수 있습니다.

또한 비디오 렌더링, 계산 금융, 기후 예측, 충돌 시뮬레이션, 유전 공학, 비선형 편집, 원격 교육 응용 프로그램 및 엔지니어링 설계와 같은 옵션을 얻을 수 있습니다.

- GA1 인스턴스는 최대 4개의 AMD FirePro S7150 GPU, 160GB 메모리 및 56개의 vCPU를 제공합니다. 병렬로 작동하고 15TFLOPS의 단정밀도와 1TFLOPS의 배정밀도를 제공하는 8192개의 코어와 32GB GPU 메모리가 포함되어 있습니다.

- GN4 인스턴스는 최대 2개의 NVIDIA Tesla M40 GPU, 96GB 메모리 및 56개의 vCPU를 제공합니다. 6000개의 코어와 14TFLOPS의 단정밀도를 제공하는 24GB GPU 메모리가 포함되어 있습니다. 마찬가지로 GN5, GN5i 및 GN6과 같은 많은 인스턴스를 찾을 수 있습니다.

- EGS는 내부적으로 25Gbit/s 및 최대 2,000,000PPS의 네트워크 대역폭을 지원하여 계산 노드에 필요한 최대 네트워크 성능을 제공합니다. SSD 또는 울트라 클라우드 디스크에 연결된 고속 로컬 캐시가 있습니다.

- 고성능 NVMe 드라이브는 230,000 IOPS를 처리하고 I/O 지연 시간은 200 𝝻이며 1900 Mbit/s의 읽기 대역폭과 1100 Mbit/s의 쓰기 대역폭을 제공합니다.

리소스를 확보하고 그에 대한 비용만 지불하기 위해 필요에 따라 다양한 구매 옵션 중에서 선택할 수 있습니다.

Azure N 시리즈

Azure N 시리즈 의 Azure VM(가상 머신)에는 GPU 기능이 있습니다. GPU는 그래픽 및 컴퓨팅 집약적 워크로드에 이상적이며 사용자가 딥 러닝, 예측 분석, 원격 시각화와 같은 다양한 시나리오를 통해 혁신을 준비할 수 있도록 지원합니다.

다른 N 시리즈에는 특정 워크로드에 대한 별도의 제품이 있습니다.

- NC 시리즈는 고성능 머신 러닝 및 컴퓨팅 워크로드에 중점을 둡니다. 최신 버전은 NVIDIA의 NVIDIA의 Tesla V100 GPU가 탑재된 NCsv3입니다.

- ND 시리즈는 기본적으로 딥 러닝을 위한 추론 및 훈련 시나리오에 중점을 둡니다. NVIDIA Tesla P40 GPU를 사용합니다. 최신 버전은 NVIDIA Tesla V100 GPU를 탑재한 NDv2입니다.

- NV 시리즈는 NVIDIA Tesla M60 GPU가 지원하는 원격 시각화 및 기타 집약적인 애플리케이션 워크로드에 중점을 둡니다.

- NC, NCsv3, ND 및 NCsv2 VM은 성능 확장을 가능하게 하는 InfiniBand 상호 연결을 제공합니다. 여기에서 딥 러닝, 그래픽 렌더링, 비디오 편집, 게임 등과 같은 이점을 얻을 수 있습니다.

IBM 클라우드

IBM 클라우드 유연성, 성능 및 다양한 GPU 옵션을 제공합니다. GPU는 CPU에 부족한 추가 브레인파워이므로 IBM Cloud는 전 세계적으로 분산된 데이터 센터 네트워크와 함께 IBM Cloud 아키텍처, 애플리케이션 및 API와의 원활한 통합을 위해 보다 액세스 가능한 서버 선택에 직접 액세스할 수 있도록 도와줍니다.

- Intel Xeon 4210, NVIDIA T4 그래픽 카드, 20코어, 32GB RAM, 2.20GHz 및 20TB 대역폭과 같은 베어메탈 서버 GPU 옵션이 제공됩니다. 마찬가지로 Intel Xeon 5218 및 Intel Xeon 6248 옵션도 제공됩니다.

- 가상 서버의 경우 8개의 vCPU, 60GB RAM, 1개의 P100 GPU가 있는 AC1.8×60이 제공됩니다. 여기에서 AC2.8×60 및 AC2.8×60 옵션도 제공됩니다.

베어메탈 서버 GPU를 월 $819의 시작 가격으로, 가상 서버 GPU를 시간당 $1.95의 시작 가격으로 구입하십시오.

AWS와 엔비디아

AWS와 엔비디아 비용 효율적이고 유연하며 강력한 GPU 기반 솔루션을 지속적으로 제공하기 위해 협력해 왔습니다. 여기에는 NVIDIA Jetson Nano 모듈과 함께 배포되는 AWS IoT Greengrass와 같은 NVIDIA GPU 기반 Amazon EC2 인스턴스 및 서비스가 포함됩니다.

사용자는 가상 워크스테이션, 기계 학습(ML), IoT 서비스 및 고성능 컴퓨팅에 AWS 및 NVIDIA를 사용합니다. NVIDIA GPU가 지원하는 Amazon EC2 인스턴스는 확장 가능한 성능을 제공합니다. 또한 AWS IoT Greengrass를 사용하여 AWS 클라우드 서비스를 NVIDIA 기반 에지 장치로 확장하십시오.

NVIDIA A100 Tensor Core GPU는 Amazon EC2 P4d 인스턴스를 구동하여 업계 최고의 저지연 네트워킹과 높은 처리량을 제공합니다. 마찬가지로 Amazon EC2 P3, Amazon EC2 G4 등과 같은 특정 시나리오에 대한 다른 많은 인스턴스를 찾을 수 있습니다.

무료 평가판을 신청하고 클라우드에서 엣지까지 GPU의 성능을 경험하십시오.

OVH클라우드

OVH클라우드 대규모 병렬 워크로드를 처리하도록 설계된 클라우드 서버를 제공합니다. GPU에는 딥 러닝 및 머신 러닝 요구 사항을 충족하기 위해 NVIDIA Tesla V100 그래픽 프로세서와 통합된 많은 인스턴스가 있습니다.

인공 지능뿐만 아니라 그래픽 컴퓨팅 분야의 컴퓨팅을 가속화하는 데 도움이 됩니다. OVH는 NVIDIA와 협력하여 고성능 컴퓨팅, AI 및 딥 러닝을 위한 최고의 GPU 가속 플랫폼을 제공합니다.

전체 카탈로그를 통해 GPU 가속 컨테이너를 배포하고 유지 관리하는 가장 간단한 방법을 사용하십시오. 가상화 계층 없이 PCI 패스스루를 통해 직접 인스턴스에 4개의 카드 중 하나를 제공하여 모든 기능을 사용자에게 제공합니다.

OVHcloud의 서비스 및 인프라는 ISO/IEC 27017, 27001, 27701 및 27018 인증을 받았습니다. 인증은 OVHcloud가 취약성을 관리하고, 비즈니스 연속성을 구현하고, 위험을 관리하고, 개인 정보 관리 시스템(PIMS)을 구현하기 위한 정보 보안 관리 시스템(ISMS)을 가지고 있음을 나타냅니다.

또한 NVIDIA Tesla V100은 PCIe 32GB/s, 16GB HBM2 용량, 900GB/s 대역폭, 배정밀도 7 테라플롭, 단정밀도 14 테라플롭, 딥 러닝 112 테라플롭과 같은 유용한 기능이 많습니다.

람다 GPU

다음을 사용하여 딥 러닝, ML 및 AI 모델 학습 람다 GPU 클라우드 클릭 몇 번으로 머신에서 총 VM 수로 확장할 수 있습니다. 사전 설치된 주요 프레임워크와 CUDA 드라이버 및 딥 러닝 프레임워크가 포함된 최신 버전의 람다 스택을 받으세요.

대시보드에서 모든 머신에 대한 전용 Jupyter Notebook 개발 환경에 빠르게 액세스할 수 있습니다. SSH 키 중 하나를 사용하여 SSH를 직접 사용하거나 클라우드 대시보드에서 웹 터미널을 통해 연결하여 직접 액세스할 수 있습니다.

모든 인스턴스는 최대 10Gbps의 노드 간 대역폭을 지원하여 Horovod와 같은 프레임워크로 분산 교육을 가능하게 합니다. 단일 또는 여러 인스턴스의 GPU 수로 확장하여 모델 최적화 시간을 절약할 수도 있습니다.

Lambda GPU Cloud를 사용하면 컴퓨팅 비용을 50% 절감하고 클라우드 TCO를 절감할 수 있으며 다년간 약정을 받을 필요가 없습니다. 6개의 VCPU, 46GiB RAM, 658GiB 임시 스토리지가 있는 단일 RTX 6000 GPU를 시간당 $1.25로 사용하십시오. 요구 사항에 따라 많은 인스턴스 중에서 선택하여 사용에 대한 온디맨드 가격을 얻으십시오.

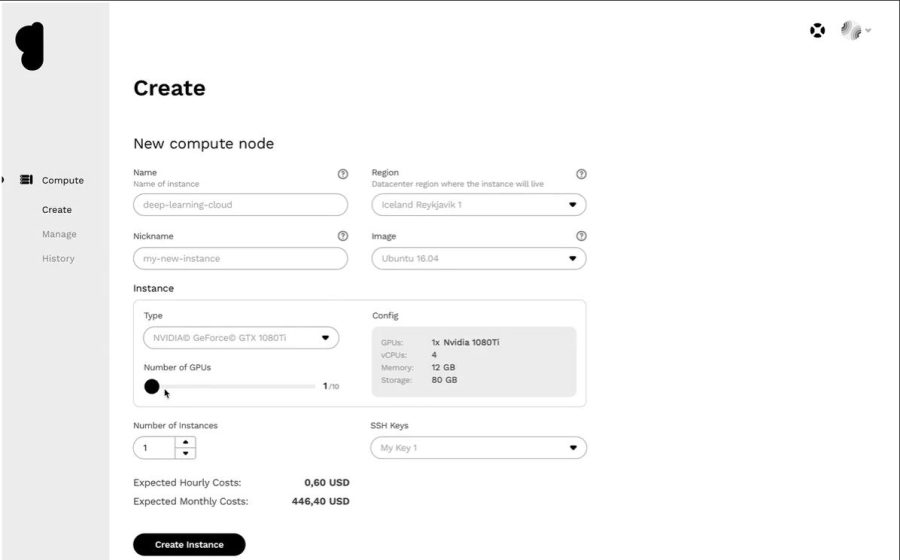

제네시스 클라우드

에서 매우 저렴한 가격으로 효율적인 클라우드 GPU 플랫폼을 얻으십시오. 제네시스 클라우드. 그들은 광범위한 애플리케이션을 제공하기 위해 협력하고 있는 전 세계의 많은 효율적인 데이터 센터에 액세스할 수 있습니다.

모든 서비스는 안전하고 확장 가능하며 강력하고 자동화되어 있습니다. Genesis Cloud는 시각 효과, 기계 학습, 트랜스코딩 또는 저장, 빅 데이터 분석 등을 위한 무제한 GPU 컴퓨팅 성능을 제공합니다.

Genesis Cloud는 작업 저장을 위한 스냅샷, 네트워크 트래픽을 위한 보안 그룹, 빅 데이터 세트를 위한 스토리지 볼륨, FastAI, PyTorch, 사전 구성된 이미지, TensorFlow용 공개 API와 같은 다양한 기능을 무료로 제공합니다.

다양한 유형의 NVIDIA 및 AMD GPU가 있습니다. 또한 GPU 컴퓨팅의 힘을 활용하여 신경망을 훈련하거나 애니메이션 영화를 생성할 수 있습니다. 그들의 데이터 센터는 탄소 배출량을 줄이기 위해 지열원에서 100% 재생 가능한 에너지로 운영됩니다.

분당 단위로 비용을 지불하게 되므로 가격은 다른 제공업체보다 85% 저렴합니다. 또한 장기 및 선점형 할인으로 더 많은 비용을 절약할 수 있습니다.

결론 👩🏫

클라우드 GPU는 놀라운 성능, 속도, 확장성, 공간 및 편의성을 제공하도록 설계되었습니다. 따라서 즉시 사용 가능한 기능을 갖춘 선호하는 클라우드 GPU 플랫폼을 선택하여 딥 러닝 모델을 가속화하고 AI 워크로드를 쉽게 처리하는 것을 고려하십시오.