스마트폰에서 글자를 입력할 때, 다음에 나올 단어가 자동으로 제시되는 것을 경험해 보셨을 겁니다. 이러한 기능은 타이핑 속도를 높여주고 시간을 절약해 주는 데 큰 도움을 줍니다.

문자 메시지를 보내거나, 인터넷 검색을 하거나, 이메일을 작성할 때, 예측 텍스트는 사용자에게 편리함을 더해줍니다. 하지만 스마트폰이 어떻게 다음에 나올 단어를 정확하게 예측하는지 궁금하지 않으셨나요?

이 글에서는 파이썬을 이용하여 단어 예측 기능을 구현하는 방법을 소개합니다.

본격적으로 시작하기 전에 자연어 처리(NLP)에 대한 기본적인 이해가 있다면 도움이 될 것입니다. NLP가 처음이더라도 걱정하지 마세요. “NLP 간편 설명”과 같은 다른 자료를 통해 기본적인 내용을 빠르게 익힐 수 있습니다.

다음 단어 예측의 활용

- 모바일 기기에서 입력 속도와 정확성을 향상시켜 문자 메시지 앱 및 커뮤니케이션 앱에서 유용하게 사용됩니다.

- 검색 엔진은 예측 텍스트를 이용하여 검색어 제안 기능을 제공함으로써 사용자가 더 빠르고 쉽게 원하는 정보를 찾을 수 있도록 합니다.

- 워드 프로세서 및 이메일 클라이언트와 같은 다양한 응용 프로그램에서 철자가 틀린 단어를 자동으로 수정하고 입력 오류를 줄이는 데 기여합니다.

- 개발자 및 프로그래머는 코드를 작성할 때 관련 함수, 메서드, 변수 이름을 제안받아 생산성을 높일 수 있습니다.

- 온라인 플랫폼과 스트리밍 서비스는 예측 텍스트를 활용하여 사용자에게 관련된 콘텐츠를 추천합니다.

이처럼 흥미로운 자연어 처리 기술이 어떻게 유용하게 활용되는지 알아보고, 각 단계를 자세히 살펴보겠습니다.

데이터 준비

가장 먼저, 프로젝트에 필요한 라이브러리를 불러와야 합니다. 그런 다음 학습에 사용할 샘플 텍스트를 설정합니다. 이 텍스트는 실제 사용하려는 텍스트 데이터로 대체할 수 있습니다.

Kaggle과 같은 플랫폼에서 텍스트 데이터가 포함된 데이터 세트를 쉽게 구할 수도 있습니다.

# 필요한 라이브러리 가져오기 import nltk from nltk import ngrams from collections import defaultdict import random

다음은 다음 단어 예측에 사용할 샘플 텍스트 데이터입니다.

# 샘플 텍스트 데이터 text = """ 옛날 옛적, 신비롭고 아름다운 별들이 빛나는 세렌디피티라는 작은 마을에 호기심 많은 젊은 탐험가 아멜리아가 특별한 모험을 시작했습니다. 그녀는 손에 든 돋보기와 불굴의 용기를 가지고 미로처럼 얽힌 숲속 깊은 곳에 숨겨진 엘리시움 보물을 찾아 나섰습니다. 푸르른 숲을 헤쳐나가던 중, 아멜리아는 수수께끼를 내며 보물의 위치를 안내하는 특이한 말을 하는 다람쥐 퍼시벌을 만났습니다. 숲은 생물발광 식물로 가득 차 있었고, 그 빛은 그녀의 길을 다채롭게 비춰주었습니다. 아멜리아는 곧 웅장하고 푸른 폭포가 내려다보이는 벼랑에 도착했고, 폭포수는 아름다운 세레나데처럼 울려 퍼졌습니다. 폭포 옆에는 고대 암호문이 새겨진 거대한 이끼 낀 돌이 서 있었습니다. 퍼시벌의 도움으로 그녀는 고대 룬 문자를 해독하고 보물 창고로 가는 입구를 찾아냈습니다. 안으로 들어가자 화려한 금 세공 장식으로 꾸며진 호화로운 상자가 나타났습니다. 상자를 열자, 반짝이는 보석, 빛나는 원석, 그리고 눈부신 유물들이 신비로운 광채를 내뿜으며 그녀를 맞이했습니다. 엘리시움 보물은 그녀의 용감한 용기와 끊임없는 호기심에 대한 증거였으며, 아멜리아는 그것을 손에 넣었습니다. 세렌디피티로 돌아온 아멜리아는 떠들썩한 축하를 받았고, 그녀의 놀라운 여정은 전설이 되어 다른 사람들에게 상상과 발견의 멋진 세계에서 자신만의 모험을 시작하도록 영감을 주었습니다. """

이 텍스트는 여러분의 필요에 따라 변경할 수 있습니다.

토큰화

이제 텍스트를 전처리하고 토큰화할 차례입니다. 토큰화란 텍스트를 개별 단어나 토큰으로 분리하는 과정입니다. 여기서는 파이썬의 nltk 라이브러리를 사용하여 텍스트를 토큰화합니다.

모델이 단어에 집중하고 대소문자나 구두점을 무시하도록 하기 위해 전처리를 수행합니다. 이 단계에서는 모든 단어를 소문자로 변환하고 구두점을 제거합니다.

import nltk # 텍스트를 단어로 토큰화 words = nltk.word_tokenize(text) # 단어 전처리 (소문자 변환, 구두점 제거) words = [word.lower() for word in words if word.isalnum()] words

전처리와 토큰화가 완료되면 모든 단어가 구두점 없이 소문자로 표시됩니다.

토큰화된 단어

토큰화된 단어

N-그램 구축

이 단계에서는 자연어 처리(NLP)에서 N개의 단어 시퀀스를 의미하는 N-그램을 생성합니다.

여기서는 N이 2인 바이그램을 생성합니다. 즉, 각 N-그램은 단어 쌍으로 구성됩니다.

이는 이전 N-1개의 단어가 제공하는 맥락을 기반으로 단어 시퀀스를 분석하고 다음 단어를 예측할 수 있도록 해주므로, 다음 단어 예측 모델을 구축하는 데 필요한 기본 단계입니다.

# N-그램 모델의 순서 정의 (바이그램의 경우 N=2)

N = 2

# 토큰화된 단어에서 N-그램 생성

ngrams_list = list(ngrams(words, N))

# N-그램과 빈도를 저장할 defaultdict 생성

ngram_freq = defaultdict(int)

for ngram in ngrams_list:

ngram_freq[ngram] += 1

이 N-그램은 다음 단어 예측 모델을 학습시키고 구현하는 데 필요한 구성 요소 역할을 합니다.

함수 정의

이 단계에서는 제공된 접두사(단어 시퀀스)를 기반으로 문장의 다음 단어를 예측하는 ‘predict_next_word’라는 함수를 생성합니다.

이 함수는 접두사가 제공하는 문맥을 가져와 가장 가능성이 높은 다음 단어를 예측하므로, 다음 단어 예측 모델에서 핵심적인 역할을 합니다.

이 과정에서 어떤 일이 일어나는지 간단하게 설명하겠습니다.

- 이 함수는 주어진 접두사(누락된 단어 앞의 단어)로 시작하는 텍스트 데이터의 모든 단어 쌍(바이그램)을 찾습니다.

- 각 단어가 해당 쌍에 얼마나 자주 나타나는지 계산하고, 빈도에 따라 가장 자주 나타나는 단어부터 정렬합니다.

- 그런 다음 함수는 주어진 접두사 다음에 가장 자주 나타나는 단어를 다음 단어로 제시합니다.

# 함수 정의

def predict_next_word(prefix):

# 주어진 접두사로 시작하는 N-그램 필터링

matching_ngrams = [(ngram, freq) for ngram, freq in ngram_freq.items() if ngram[:-1] == prefix]

if not matching_ngrams:

return "예측 가능한 단어가 없습니다."

# 빈도수를 기준으로 N-그램을 내림차순으로 정렬

sorted_ngrams = sorted(matching_ngrams, key=lambda x: x[1], reverse=True)

# 가장 높은 빈도를 가진 N-그램을 예측값으로 선택

prediction = sorted_ngrams[0][0][-1]

return prediction

이 함수는 주어진 텍스트 시퀀스에서 다음 단어에 대한 문맥상 적절한 제안을 생성할 수 있도록 해주므로, 다음 단어 예측 모델에서 핵심적인 부분입니다.

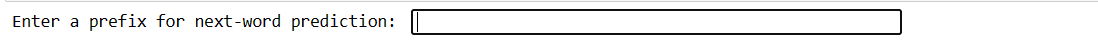

테스트

이 코드를 사용하여 사용자가 입력한 값으로 모델을 테스트할 수 있습니다. 몇 단어를 입력하고 Enter 키를 누르면 모델이 다음 단어를 예측합니다. 잘못된 내용을 입력하면 다시 시도하라는 메시지가 표시됩니다.

# 사용자 입력으로 모델을 대화형으로 테스트하는 코드 스니펫

user_input = input("다음 단어 예측을 위한 접두사를 입력하세요: ").lower().split()

if len(user_input) != N - 1:

print("유효한 접두사를 입력하세요.")

else:

prefix = tuple(user_input)

prediction = predict_next_word(prefix)

print(f"다음 단어 예측: {prediction}")

이 코드는 사용자가 접두어를 입력하고 Enter 키를 누를 수 있는 인터페이스를 생성합니다.

접두어 입력

접두어 입력

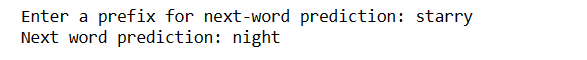

Enter 키를 누르면 다음 단어가 표시됩니다.

예측된 단어

예측된 단어

이것이 다음 단어 예측 모델이 실제로 어떻게 사용될 수 있는지 보여주는 방법입니다.

과제:

- 다음 단어 예측의 정확도는 학습 데이터의 크기와 품질에 따라 크게 달라집니다. 제한적이거나 노이즈가 많은 데이터는 예측 정확도를 떨어뜨릴 수 있습니다.

- 입력 텍스트에 있는 단어가 학습 데이터에 없는 경우 정확하게 예측할 수 없습니다.

- 구두점은 특히 단어 경계가 모호할 수 있는 영어와 같은 언어에서 예측 정확도에 영향을 미칠 수 있습니다.

- 잘못된 토큰화 또는 전처리는 잘못된 예측을 초래할 수 있습니다.

- 많은 단어는 여러 가지 의미를 가지고 있으며 문맥에 따라 그 의미가 항상 명확하지 않을 수 있습니다.

정확도를 높이는 방법

- 더 크고 다양한 데이터 세트를 사용하면 다양한 문맥과 단어에 대한 모델의 이해가 향상됩니다.

- 더 많은 문맥을 위해 고차 N-그램(예: 트라이그램)을 사용하는 것을 고려하되, 데이터 가용성과 균형을 맞춰야 합니다.

- 사용자 피드백을 수집하고 실제 사용을 기반으로 모델을 지속적으로 개선해야 합니다.

- 적절한 지표를 사용하여 모델 성능을 정기적으로 평가하고, 이에 따라 전략을 조정해야 합니다.

- 보다 복잡한 문맥 모델링을 위해 LSTM 또는 트랜스포머와 같은 신경망 기반 모델을 구현할 수 있습니다.

마지막 말

자연어 처리 분야에서 다음 단어를 예측하는 것은 매우 중요한 기술입니다. 이 5가지 간단한 파이썬 단계를 통해, 더 빠른 커뮤니케이션과 더 스마트한 기술을 위한 강력한 도구를 얻을 수 있습니다.

언어 경험을 향상시키기 위해 이 지식을 계속 탐구하고 활용하십시오. 여정은 이제 막 시작되었을 뿐입니다!

파이썬을 사용하여 URL에서 파일을 다운로드하는 가장 좋은 방법을 탐구할 수도 있습니다.